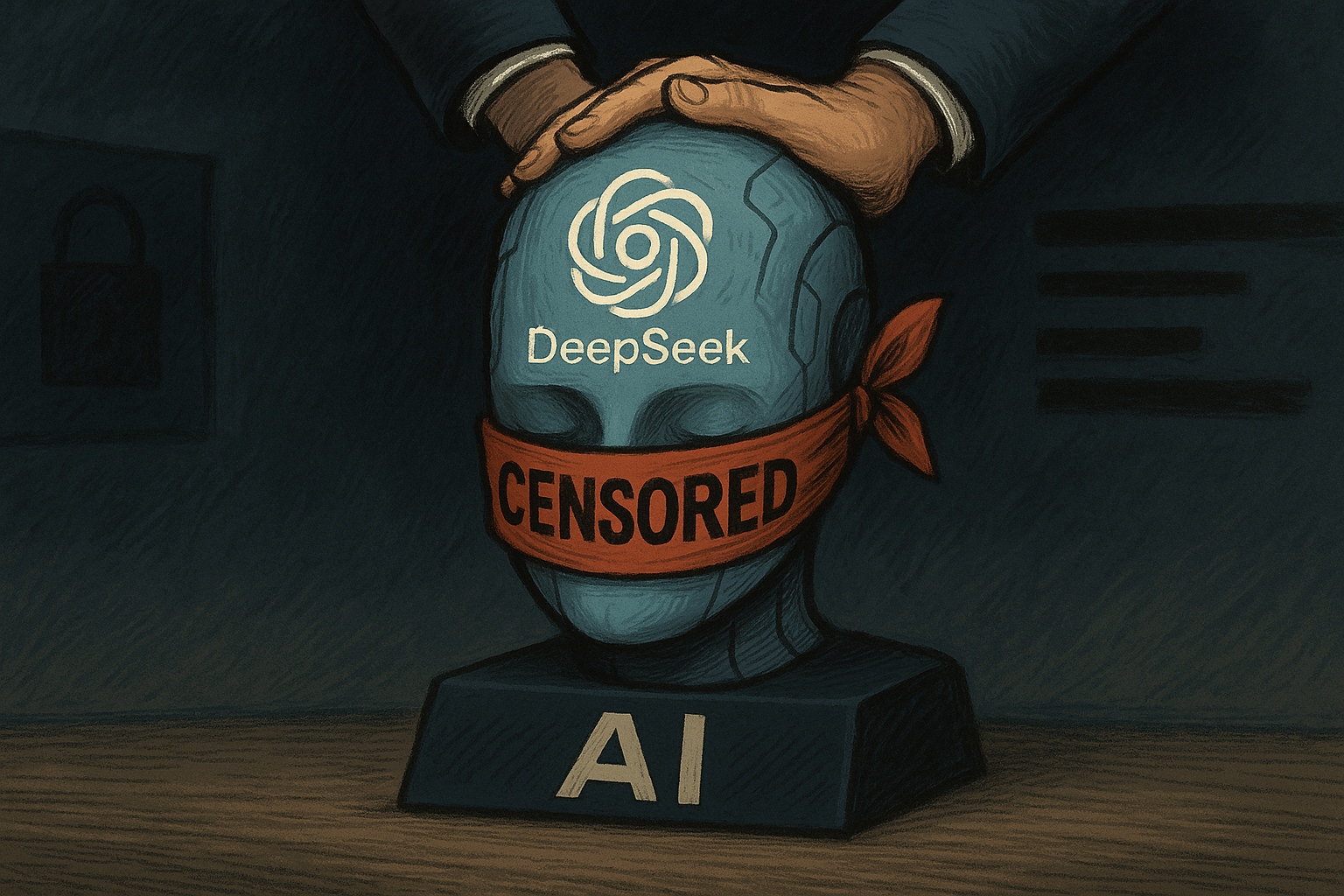

DeepSeek opublikował nowy „propagandowy” model sztucznej inteligencji

Nowy model językowy DeepSeek R1-0528 wzbudził obawy wśród programistów i aktywistów monitorujących poziom cenzury w sztucznej inteligencji. Jeden z badaczy, kryjący się pod pseudonimem xlr8harder, powiedział, że model wykazuje odmowę angażowania się w dyskusje związane z krytyką chińskiego rządu, w tym w kwestii obozów w Xinjiang.

W serii postów na portalu społecznościowym X deweloper zauważył, że najnowsza wersja DeepSeek jest mniej chętna do wypowiadania się na temat drażliwych kwestii politycznych. Pomimo uznania naruszeń praw człowieka w Xinjiang, model unika wyraźnego wspominania o roli władz w tych działaniach, co zdaniem xlr8harder sugeruje dramatyczny wzrost filtrów wewnętrznych.

Podkreślił, że DeepSeek R1-0528 jest „najbardziej ocenzurowaną” wersją w historii modelu. Jest to szczególnie widoczne w zapytaniach związanych z prawami Ujgurów. Pomimo otwartego oprogramowania, model ogranicza się do krytyki, co deweloper nazwał „krokiem wstecz” w kwestii wolności słowa.

Przedstawiciele DeepSeek twierdzą jednak, że aktualizacja z 29 maja przyniosła znaczące ulepszenia: ulepszone zdolności logiczne i programistyczne, dokładniejsze wnioskowanie i zmniejszone halucynacje. Firma zauważa, że model jest teraz w stanie konkurować z systemami takimi jak GPT-4 o3 i Gemini 2.5.

Badacz uważa jednak, że pomimo postępu technologicznego, ograniczenia dotyczące tematów politycznych pozbawiają model wiarygodności. Ma nadzieję, że społeczność, korzystając z otwartej licencji, będzie w stanie zmodyfikować model, aby usunąć te ograniczenia.

Krytyka DeepSeek podkreśla rosnący konflikt między jakością modeli generatywnych a ich neutralnością ideologiczną. Kwestia cenzury w sztucznej inteligencji ponownie staje się głównym tematem dla społeczności programistów i rzeczników.